您是否曾经在 Google 上搜索过某些内容并想知道:“它怎么知道去哪里找?” 答案是“网络爬虫”,它搜索网络并将其编入索引,以便您可以轻松地在线查找内容。我们会解释。

搜索引擎和爬虫

当您在 Google 或Bing等搜索引擎上使用关键字进行搜索时,该网站会筛选数万亿个页面以生成与该术语相关的结果列表。这些搜索引擎究竟是如何将所有这些页面存档的,知道如何查找它们并在几秒钟内生成这些结果的?

答案是网络爬虫,也称为蜘蛛。这些是自动程序(通常称为“机器人”或“机器人”),它们“爬行”或浏览整个网络,以便将它们添加到搜索引擎中。这些机器人索引网站以创建最终出现在您的搜索结果中的页面列表。

爬虫还会在引擎的数据库中创建和存储这些页面的副本,这使您几乎可以立即进行搜索。这也是搜索引擎经常在其数据库中包含网站缓存版本的原因。

站点地图和选择

那么,爬虫是如何选择要爬取哪些网站的呢?嗯,最常见的情况是网站所有者希望搜索引擎抓取他们的网站。他们可以通过请求谷歌、必应、雅虎或其他搜索引擎为其页面编制索引来实现这一点。这个过程因发动机而异。此外,搜索引擎经常通过跟踪 URL 在其他公共站点上的链接次数来选择流行的、链接良好的网站进行抓取。

网站所有者可以使用某些流程来帮助搜索引擎为其网站编制索引,例如

上传站点地图。这是一个包含属于您网站的所有链接和页面的文件。它通常用于指示您希望将哪些页面编入索引。

一旦搜索引擎已经抓取了一个网站,它们将再次自动抓取该网站。频率根据网站的受欢迎程度以及其他指标而有所不同。因此,网站所有者经常保持更新的网站地图,让引擎知道要索引哪些新网站。

机器人和礼貌因素

如果网站 不 希望其部分或全部页面出现在搜索引擎上怎么办?例如,您可能不希望人们搜索仅限会员的页面或查看您的404 错误页面。这就是抓取排除列表(也称为 robots.txt)发挥作用的地方。这是一个简单的文本文件,它指示爬网程序从索引中排除哪些网页。

robots.txt 很重要的另一个原因是网络爬虫可以对网站性能产生重大影响。因为爬虫实际上是在下载您网站上的所有页面,所以它们会消耗资源并可能导致速度变慢。他们在不可预测的时间到达并且未经批准。如果您不需要重复索引您的网页,那么停止爬虫可能有助于减少您的网站负载。幸运的是,大多数抓取工具会根据网站所有者的规则停止抓取某些页面。

元数据魔法

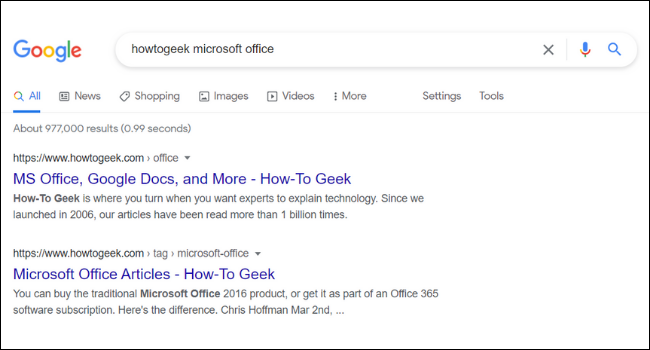

在 Google 中每个搜索结果的 URL 和标题下,您会找到该页面的简短描述。这些描述称为片段。您可能会注意到,Google 中的网页摘要并不总是与网站的实际内容一致。这是因为许多网站都有称为“元标记”的东西,它们是网站所有者添加到其页面的自定义描述。

网站所有者经常会想出诱人的元数据描述来让您想点击网站。Google 还列出了其他元信息,例如价格和库存情况。这对于那些运行电子商务网站的人来说尤其有用。

您的搜索

网络搜索是使用互联网的重要组成部分。搜索网络是发现新网站、商店、社区和兴趣的好方法。每天,网络爬虫都会访问数百万个页面并将它们添加到搜索引擎中。虽然爬虫有一些缺点,比如占用网站资源,但它们对网站所有者和访问者来说都是无价的。

未经允许不得转载:表盘吧 » 什么是网络爬虫,它是如何工作的?