训练大型语言模型是 AI 开发的关键部分,但这也是一个可能需要花费大量时间并消耗大量计算能力的过程。这就是 Moonshot 的 Unsloth 的用武之地,可让您更快地训练 LLM。他们创建了一个新的软件包,在训练这些模型的速度和效率方面取得了重大进步。它旨在与 NVIDIA、Intel 和 AMD 等顶级公司的各种图形处理单元 (GPU) 配合使用。 U...

训练大型语言模型是 AI 开发的关键部分,但这也是一个可能需要花费大量时间并消耗大量计算能力的过程。这就是 Moonshot 的 Unsloth 的用武之地,可让您更快地训练 LLM。他们创建了一个新的软件包,在训练这些模型的速度和效率方面取得了重大进步。它旨在与 NVIDIA、Intel 和 AMD 等顶级公司的各种图形处理单元 (GPU) 配合使用。 U...

Perplexity还是开始自己训练模型了,公布了自己训练的两个pplx-7b-chat 和 pplx-70b-chat模型。 主要的特点是优先保证一系列任务的智力、有用性和多功能性,而不强加道德判断或限制。 与llama-2-70b-chat相比较完全拒绝”的情况减少了22.7%,而“没有拒绝”的情况增加了31.9%。 估计是被 Open AI 和 Cla...

![]() 1

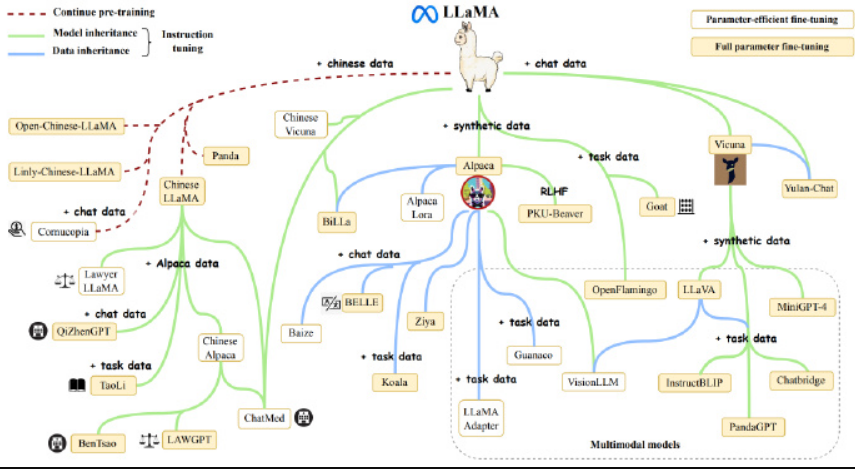

1ChatGPT 引发的大模型热潮愈演愈烈,全球科技巨头和明星初创争相入局,打造以 AI 大模型为核心的竞争力和多样化商业使用需求。 LLaMA 系列模型,因良好的基础能力和开放生态,已积累了海量的用户和实际应用案例,成为无数开源模型后来者的模仿和竞争的标杆对象。 如何降低类 LLaMA2 大模型预训练成本,如何基于 LLaMA2 通过继续预训练和微调,低成本...