Microsoft 和 Nvidia 是合作伙伴,在云、游戏和集成方面开展多个项目。在两家公司之间的最新工作中,微软和英伟达展示了能够提高视频序列 AI 训练速度的研究。

在一篇题为“用于视频表示学习的参数高效多模态转换器”的论文中,研究人员讨论了他们如何将多模态转换器的大小减少 97%,以改进 30 秒视频剪辑的 AI 训练(以 480 帧采样,每秒 16 帧)。这是对现有模型的重大改进,可以处理 10 秒或更短的视频序列。

微软和英伟达指出,学习和理解视频是人工智能面临的最大挑战之一。让 AI 高效学习多模态表示是理解视频(例如动作、对象和音频)的基础。最近的多模态转换器已经变得擅长理解视频序列的各个方面,例如视觉和语言,或图像识别。

尽管如此,训练多模态转换器 AI 仍然是一个挑战,因为它需要大量内存。微软在一篇博文中表示,许多现有的 Transformer 只是利用现有的预训练模型来训练自己。

减少模型负载

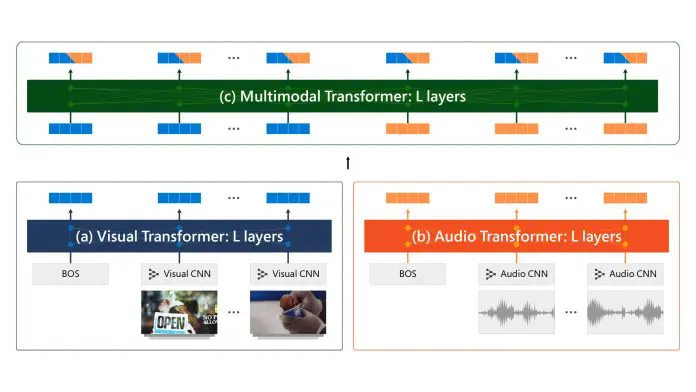

微软和英伟达进行了重大改进,使模型能够更有效地训练新的视频序列。该模型有五个组成部分:音频和视觉卷积神经网络 (CNN)、音频和视觉转换器以及多模态转换器。

CNN 在 1 秒视频序列上同时包含视觉信号和音频信号,变压器对来自 30 秒输入序列的视觉、音频和视听信号进行编码。微软承认,在 GPU 上训练该模型仍然是内存密集型的,因为它包含 1.55 亿个权重参数,而三个转换器总共消耗了总参数的 1.28 亿(82.6%)。

微软和英伟达没有接受小批量和更长的训练周期,而是决定拆分权重参数以减少模型大小。两家公司的研究人员都使用了两种方法来实现这一目标:

- “第一种策略在每个转换器内的层之间共享权重,将转换器视为展开的循环网络。如图 2(b) 所示,这将参数减少了 83%(从 1.28 亿减少到 2200 万)。

- 第二种策略涉及使用低秩分解的部分权重共享,我们将变压器的每个权重矩阵分解为 W=UΣV 的形式,并在变压器之间共享 U,同时保持 ΣV 对每个变压器私有。”

总的来说,研究团队能够将变压器的参数使用量从 1.28 亿个减少到仅 400 万个。

未经允许不得转载:表盘吧 » 微软和 Nvidia 合作实现 AI 视频培训突破