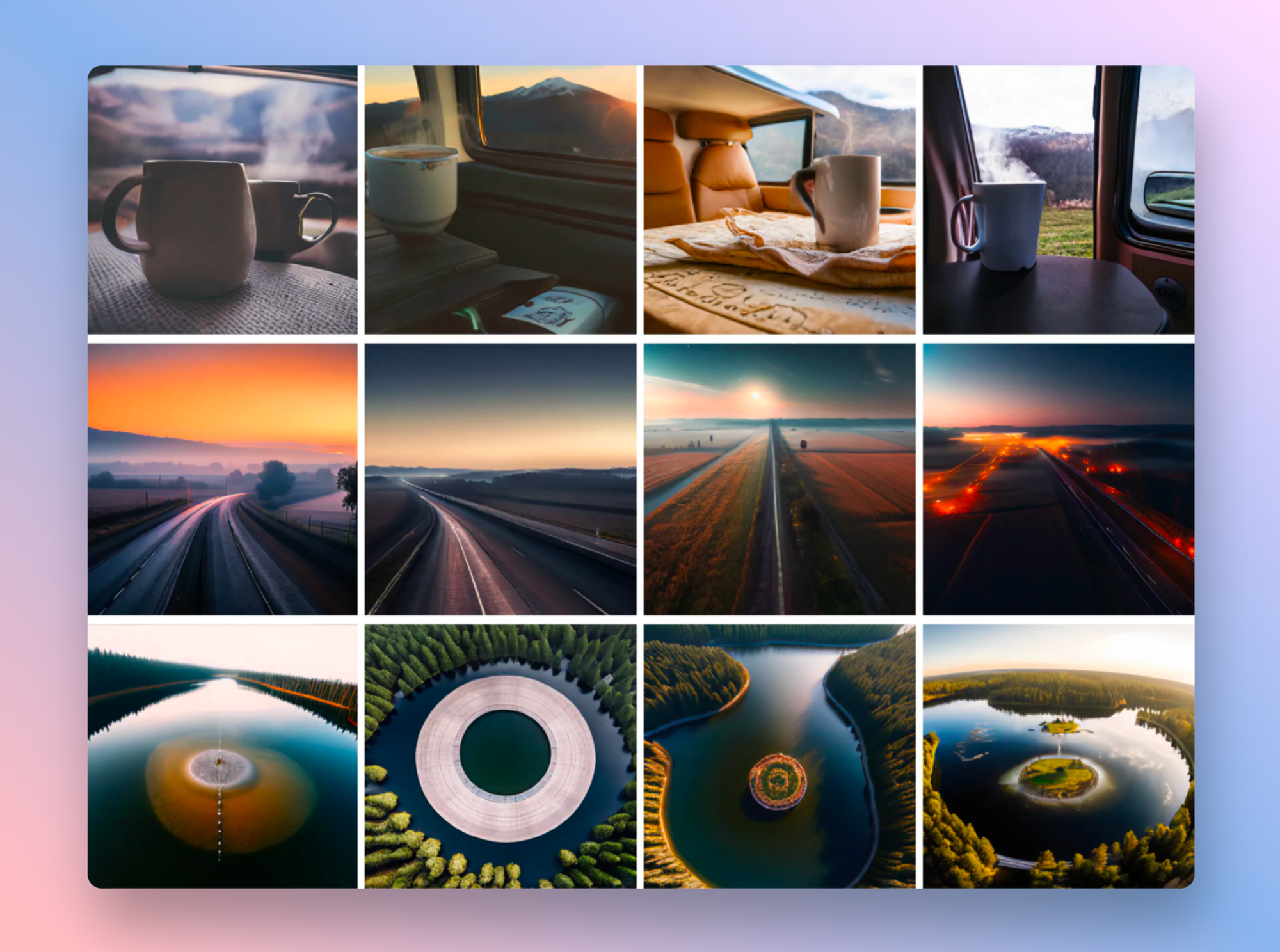

上周 Meta 推出了他们的多模态模型 CM3leon 这是一个既能进行文本到图像生成,又能进行图像到文本生成的单一基础模型。从图象生成的质量来看,感觉比 SDXL 要好很多的。

CM3leon是第一个使用从仅文本语言模型中改编的配方进行训练的多模态模型,包括大规模的检索增强预训练阶段和第二个多任务监督微调(SFT)阶段。它能实现下面这些功能:

- 文本转图像:给定具有潜在高度组合结构的提示文本,生成遵循提示的连贯图像。

- 文本引导图像编辑:给定图像和文本提示,根据文本中的说明编辑图像。由于 CM3leon 模型的通用性,这是通过与上面和下面的所有其他任务相同的模型来实现的,这与之前的模型(例如 InstructPix2Pix)不同,后者仅针对文本引导图像编辑进行了调整。

- 文本任务:CM3leon 模型还可以按照一系列不同的提示生成短或长的标题并回答有关图像的问题。

- 结构引导图像编辑:结构引导图像编辑不仅涉及理解和解释文本指令,还涉及作为输入提供的结构或布局信息。这使得 CM3leon 模型能够对图像进行视觉上连贯且上下文适当的编辑,同时遵守给定的结构或布局指南。

- 物体到图像:给定图像边界框分割的文本描述,生成图像。

- 图像分割:给定仅包含分割的图像(没有文本类),生成图像。这里的输入表示我们从中提取分割的图像。

- 生成超分辨率结果:图像生成的一个常见技巧是添加单独训练的超分辨率阶段,以从原始模型输出生成更高分辨率的图像。这对于 CM3leon 也非常有效。

未经允许不得转载:表盘吧 » Meta 推出 CM3leon 多模态文本和图象生成模型