微软的神经文本到语音(Neural TTS) 正在达到一个新的里程碑,因为它在 Microsoft Azure 上播放了一个新版本。据该公司称,该平台的最新版本 Neural TTS Uni-TTSv4 相当于说话时的句子级自然语音录音。

如果您不熟悉 Neural TTS,它在三年前首次推出。即使在那时,微软也声称它在将文本翻译成语音时“接近人类水平”。换句话说,该平台提供尽可能自然的文本语音音频播放。

从那时起,微软一直在改进其 Azure 云平台的神经文本到语音转换。虽然您可能不会直接使用该工具,但它已融入您可能使用的大量 Microsoft 产品中,例如 Word 的朗读功能、Edge 中的沉浸式阅读器等。许多 Microsoft 合作伙伴也采用了 Neural TTS。

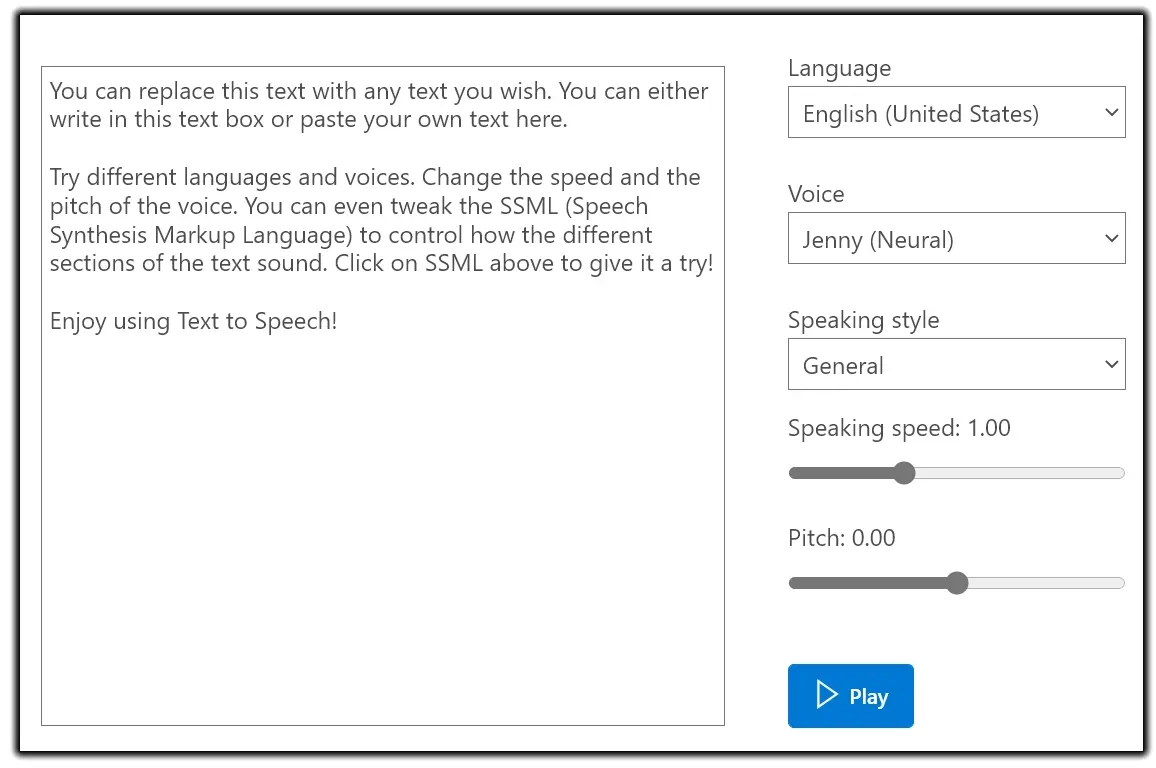

通过 Uni-TTSv4,Microsoft 正在向这些合作伙伴和服务提供改进版本。这意味着,当您使用这些功能时,性能会更好。您仍然可以在一堆预设声音之间进行选择,甚至可以录制自己的样本。

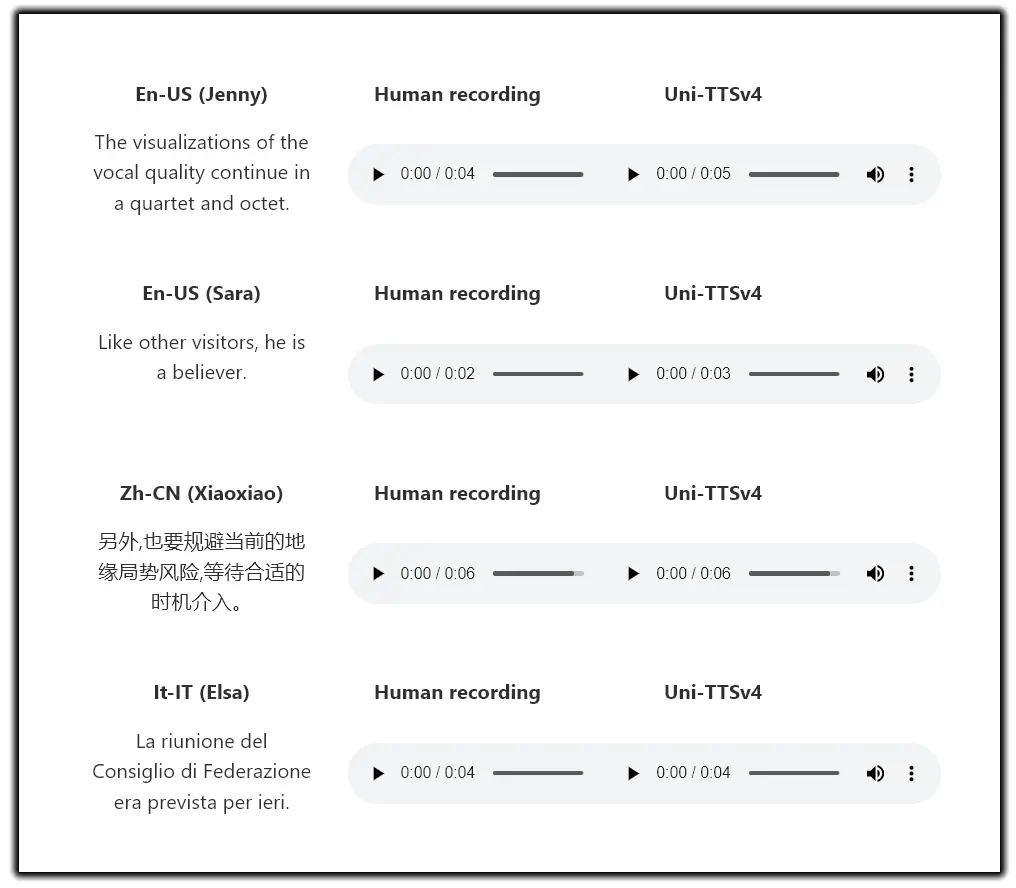

然而,虽然 Neural TTS 支持超过 110 种语言,但 Uni-TTSv4 目前仅提供以下八种语音:

微软表示其他语言将很快获得更新,自定义语音也是如此。用户无需执行任何操作,因为该工具会在 Microsoft Office 和 Microsoft Edge 中自动更新。

测试

在宣布新版本的博客文章中,Microsoft 解释了它如何衡量文本到语音转换以确保 Neural TTS 提供最佳质量。所有 TTS 模型都通过平均意见得分 (MOS) 来衡量,这是一种流行的语音质量测试服务。

“对于 MOS 研究,参与者以五分制对人声录音和 TTS 语音的语音特征进行评分,”微软解释说。

“这些特征包括音质、发音、语速和发音。对于任何模型改进,我们首先与生产模型进行并排比较 MOS 测试 ( CMOS )。然后,我们对保留的录音集(未在训练中使用的录音)和 TTS 合成音频进行盲 MOS 测试,并测量两个 MOS 分数之间的差异。”

此外,微软将 Uni-TTSv4 模型发送到 2021 年暴雪挑战赛,这是一个流行的 TTS 基准测试,允许跨多个系统进行 MOS 测试。微软表示,其测试新语音模型的结果“与普通数据集上的自然语音没有显着差异”。

下面是测试结果,显示了 Uni-TTSv4 的 8 个可用模型与其他模型的比较:

| 现场(语音) 人工录音 (MOS) |

Uni-TTSv4 (MOS) | 威尔科克森 p 值 | CMOS | 生产线 |

| En-US (珍妮) | 4.33(±0.04) | 4.29(±0.04) | 0.266 | +0.116 |

| En-US (Sara) | 4.16(±0.05) | 4.12 (±0.05) | 0.41 | +0.129 |

| zh-CN (潇潇) | 4.54(±0.05) | 4.51(±0.05) | 0.44 | +0.181 |

| 它-IT (艾尔莎) | 4.59(±0.04) | 4.58(±0.03) | 0.34 | +0.25 |

| Ja-JP(七海) | 4.44(±0.04) | 4.37(±0.05) | 0.053 | +0.19 |

| Ko-KR(善喜) | 4.24(±0.06) | 4.15(±0.06) | 0.11 | +0.097 |

| Es-ES(阿尔瓦罗) | 4.36(±0.05) | 4.33(±0.04) | 0.312 | +0.18 |

| Es-MX (达利亚) | 4.45 (±0.05) | 4.39(±0.05) | 0.103 | +0.076 |

这是什么意思?

所有这些测试和技术改进都很好,但这在现实世界中意味着什么?嗯,微软近年来的增量更新让模型变得更接近人类语音的真实性。

不过,该公司承认仍有改进的空间,尤其是当用户长时间收听 TTS 时。在这种情况下,Microsoft 指出语音的音调和语气将失去一些质量。

这是因为人类的语音非常微妙,充满了动态,而且音调和音调几乎不断发生轻微变化。

“目前,这些参数对人类语音声谱上的所有粗粒度和细粒度细节进行建模并不是很有效。TTS 也是一个典型的一对多映射问题,其中对于给定的文本输入可能有多个不同的语音输出(例如,音高、持续时间、说话者、韵律、风格等)。因此,对此类变化信息进行建模对于提高合成语音的表现力和自然度非常重要。”

Uni-TTSv4 通过对声学建模方式的两项更改来解决局限性。具体来说,带有转换器模型的新架构允许改进,而变化现在由一个模型处理,该模型将显式视角(说话者 ID、语言 ID、音调和持续时间)和隐式视角(话语级和音素级韵律)分开。

未经允许不得转载:表盘吧 » Microsoft Azure 为神经 TTS 破解了人类级别的文本到语音播放